Искусственный интеллект обыграл чемпиона в Го

29 января 2016 года

Программа AlphaGo, разработанная подразделением Google DeepMind, впервые в истории смогла обыграть профессионального игрока в го Фань Хуэя — трёхкратного[1] чемпиона Европы, обладающего 2 даном в этой игре.

Матч из пяти партий между AlphaGo и Фань Хуэем состоялся ещё в октябре 2015 года и закончился сухой победой программы со счётом 5-0. Однако ведущий научный журнал Nature опубликовал статью об этом лишь среду, 27 января 2016 года, отмечая, что это событие сравнимо с победой разработанной IBM программы Deep Blue над чемпионом мира по шахматам Гарри Каспаровым в 1997 году. Уже в 2005 году человек в последний раз выиграл у лучшего алгоритма. С тех пор компьютерные программы могут обыграть любого игрока в шахматы.

По словам Фаня Хуэя, программа играла очень по-человечески:

| Если бы меня заранее не предупредили, я бы мог решить, что против меня играет немного странный, но очень сильный живой игрок. |

Матчу предшествовало соревнование AlphaGo с другими программами по игре в го, в котором разработка DeepMind выиграла 494 матча из 495. По данным разработчиков программа побеждает других игроков в 99,8 процента случаев.

В марте 2016 года разработчики рассчитывают устроить в Сеуле матч AlphaGo против Ли Седоля — корейского го-профессионала высшего 9 дана — одного из сильнейших го-игроков в мире. Первый профессиональный дан он получил в возрасте 13 лет. В случае победы Ли получит от Google 1 млн долларов США, а в случае поражения компания отдаст эти деньги на благотворительность.

Эксперты считают, что китайская игра го значительно сложнее шахмат. Представитель подразделения Google Демис Хассабис (англ. Demis Hassabis), который принимал непосредственное участие в разработке программы, подчёркивает, что в го значительно больше ходов и комбинаций, чем в шахматах, а значит, сложность выбора варианта увеличивается на несколько порядков.

В январе 2016 года математик Джон Тромп (англ. John Tromp) опубликовал подсчёт числа возможных не противоречащих правилам комбинаций камней в го при игре на стандартном гобане размером 19×19. Получившееся число оказалось больше, чем количество атомов в наблюдаемой Вселенной, а именно[2]:

| 208 168 199 381 979 984 699 478 633 344 862 770 286 522 453 884 530 548 425 639 456 820 927 419 612 738 015 378 525 648 451 698 519 643 907 259 916 015 628 128 546 089 888 314 427 129 715 319 317 557 736 620 397 247 064 840 935 |

Именно по этой причине задача выигрышной стратегии в го была долгое время недоступна для классических алгоритмов, работающих по методу выбора оптимального движения по дереву вариантов.

Ранее компьютерные программы несколько раз выигрывали партии в го у профессиональных игроков, имея фору в несколько камней, а также играя с профессионалами на малых досках для неофициальных игр.

Президента британской ассоциации го Джон Даймонд сказал:

| До этого матча я думал, что пройдёт минимум 5-10 лет, прежде чем программа сможет обыграть ведущих игроков. |

Разработка алгоритмов, которые обеспечивали бы обучение программы и принятие решений за время, сопоставимое со скоростью профессионального игрока в го, заняла несколько лет. Достигнутые результаты впечатляют, однако Хассабис не скрывает, что AlphaGo предстоит провести миллионы партий, чтобы играть, как чемпионы.

Разработчики AlphaGo использовали метод самообучающейся сети — изначально алгоритм не учили играть и выигрывать в го — нейросеть самостоятельно обучалась игре на примере реальных партий. В AlphaGo используются две глубокие нейронные сети (англ. deep neural networks, англ. DNN; см: Глубинное обучение). Всего программа за период обучения обработала 30 миллионов комбинаций, что позволило ей выработать аналог интуитивной игры у человека.

В сочетании с основным алгоритмом разработчики всё же использовали и традиционный метод перебора наилучших вариантов, которые используют слабые го-алгоритмы или программы, специализирующиеся в других играх.

Победа в го не является основной целью для создателей программы. По словам разработчиков программы, алгоритмы, разработанные для этой игры, будут использоваться при создании сложного медицинского оборудования. Интеллектуальная система принятия решений поможет с постановкой диагноза и предоставит врачу возможные варианты лечения. По словам Демиса Хассабиса, разработанные с помощью AlphaGo продукты и сервисы могут появиться в течение одного-двух лет.

Ранее глава Facebook Марк Цукерберг рассказал, что его компания также разрабатывает систему искусственного интеллекта для игры в го. Вполне возможно, что мы увидим противостояние Google и Facebook в этой сфере.

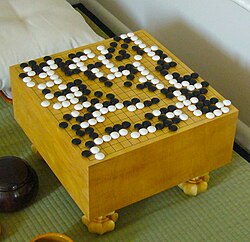

Го (яп. 碁; также кит. 围棋 вэйци, кор. 바둑 падук) — логическая настольная игра с глубоким стратегическим содержанием, возникшая в Древнем Китае, по разным оценкам, от 2 до 5 тысяч лет назад. До XIX века культивировалась исключительно в Восточной Азии, в XX веке распространилась по всему миру. В настоящее время в Международную федерацию го входят 75 стран. По общему числу игроков го — одна из самых распространённых настольных игр в мире. Входит в число пяти базовых дисциплин Всемирных интеллектуальных игр.

| Продолжение: Началась прямая трансляция игр ИИ с чемпионом мира по Го: в первой партии победила AlphaGo |

Примечания

править- ↑ По другим данным — двукратного.

- ↑ Код программы доступн на GitHub.

См. также

править- Видео:

- The computer that mastered Go // Nature.

- Google DeepMind: Ground-breaking AlphaGo masters the game of Go // DeepMind.

- Партии:

Источники

править- David Silver, Aja Huang, Chris J. Maddison, Arthur Guez, Laurent Sifre Mastering the game of Go with deep neural networks and tree search (Английский) // Nature. — 2016-01-28. — В. 7587. — Т. 529. — С. 484–489. — DOI:10.1038/nature16961

- Demis Hassabis «AlphaGo: using machine learning to master the ancient game of Go». Google, 27 января 2016 года. (архив)

- Alistair Barr, Jack Nicas «Google Parent Claims Artificial-Intelligence Victory in Go Game Win». The Wall Street Journal, 27 января 2016 года. (архив)

Искусственный интеллект впервые победил профессионального игрока в го(рус.) (неопр.) ?. Meduza. Дата обращения: 27 января 2016.

- Николай Воронцов «Алгоритм Google обыграл в го чемпиона Европы». nplus1.ru, 27 января 2016 года. (архив)

- Николай Воронцов «Точное количество разрешенных комбинаций в го оказалось больше числа атомов во Вселенной». nplus1.ru, 25 января 2016 года. (архив)

- Алексей Невельский «Компьютер научился играть в го лучше людей». Ведомости, 206-01-28. (архив)

- «Искусственный интеллект впервые в мире победил профессионального игрока в го». geektimes.ru, 28 января 2016 года. (архив)

| Эта статья содержит принадлежащие интернет-холдингу Mail.ru материалы из статьи «Компьютер впервые выиграл у чемпиона в шашки го», опубликованной на сайте Hi-Tech@Mail.ru и распространяющейся на условиях лицензии Creative Commons Attribution 3.0 Unported (CC-BY 3.0 Unported). Автор текста: Ксения Шестакова |

Комментарии

Если вы хотите сообщить о проблеме в статье (например, фактическая ошибка и т. д.), пожалуйста, используйте обычную страницу обсуждения.

Комментарии на этой странице могут не соответствовать политике нейтральной точки зрения, однако, пожалуйста, придерживайтесь темы и попытайтесь избежать брани, оскорбительных или подстрекательных комментариев. Попробуйте написать такие комментарии, которые заставят задуматься, будут проницательными или спорными. Цивилизованная дискуссия и вежливый спор делают страницу комментариев дружелюбным местом. Пожалуйста, подумайте об этом.

Несколько советов по оформлению реплик:

- Новые темы начинайте, пожалуйста, снизу.

- Используйте символ звёздочки «*» в начале строки для начала новой темы. Далее пишите свой текст.

- Для ответа в начале строки укажите на одну звёздочку больше, чем в предыдущей реплике.

- Пожалуйста, подписывайте все свои сообщения, используя четыре тильды (~~~~). При предварительном просмотре и сохранении они будут автоматически заменены на ваше имя и дату.

Обращаем ваше внимание, что комментарии не предназначены для размещения ссылок на внешние ресурсы не по теме статьи, которые могут быть удалены или скрыты любым участником. Тем не менее, на странице комментариев вы можете сообщить о статьях в СМИ, которые ссылаются на эту заметку, а также о её обсуждении на сторонних ресурсах.